تاریخچه دیپ لرنینگ

در این بخش قرار است به تاریخچه دیپ لرنینگ بپردازیم.

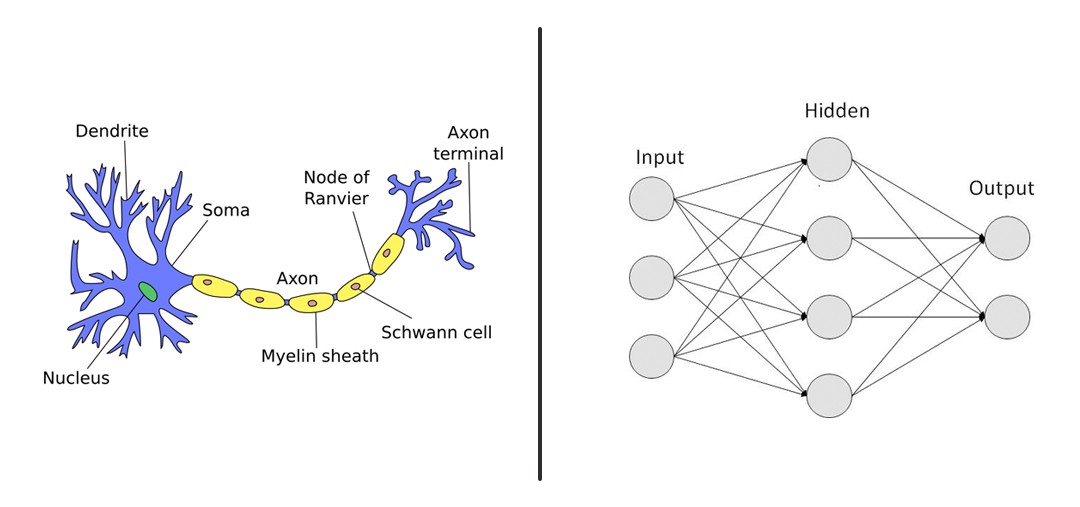

در سال 1962 آقای Frank Rosenblatt کتابی به نام Principles of Neurodynamics را نوشته اند. در این کتاب تئوریهایی در خصوص فلسفه این که یک سیستم میتواند شبیه مغز انسان عمل و فکر کند، مطرح شده است. در سال 1967 آقای Alexey Ivakhnenko یک شبکه عصبی چند لایه را به نام Multilayer Perceptron(MLP) را ایجاد کردند. از این شبکه در الگوریتمهای supervised learning در بخش feedforward استفاده کردند که این تاریخ نقطه آغاز مبحث MLP میباشد.

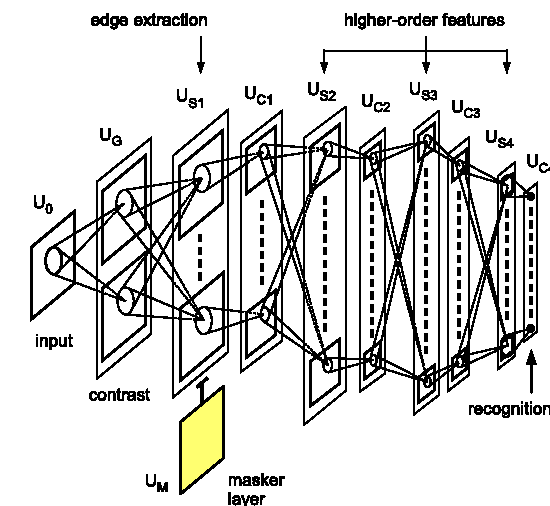

در سال 1971 مقاله ایی در این زمینه منتشر شد که در آن از یک شبکه عصبی 8 لایه استفاده شده بود. با مطرح شدن این الگوریتم و استفاده از آن بحث شبکههای دیپ لرنینگ یک مقدار رونق پیدا کرد. در سال 1980 اتفاق مهمی در خصوص شبکههای عمیق رخ داد. آقای Kunihiko Fukushima یک مدلی را به نام Neocognitron پیشنهاد دادند که این مدل برای کاربرد computer vision در مباحث دیپ لرنینگ ساخته شده بود. این موضوع یک پایه مهمی برای تحقیقات بیشتر در این خصوص بود.

شروع سالهای طلایی

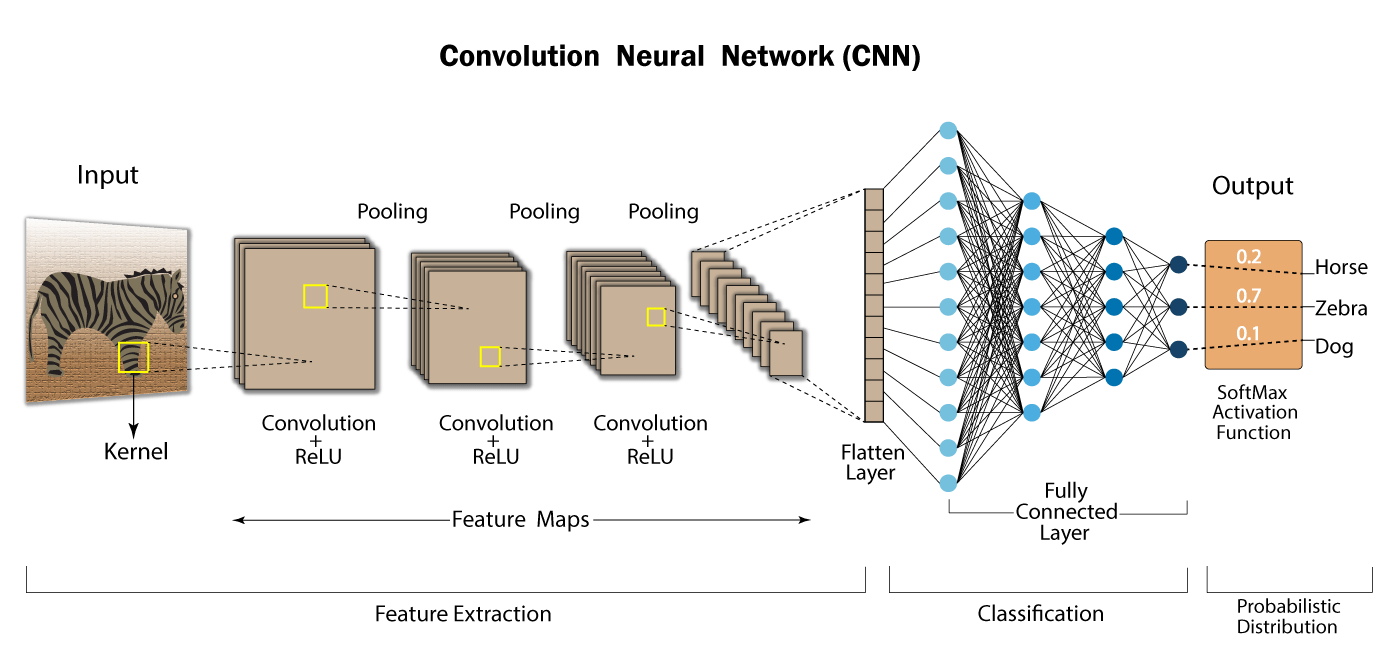

سال 1989 یکی از سالهای طلایی دیپ لرنینگ است. اولین توجه مهم به این مبحث در این سال اتفاق افتاد. آقای پروفسور Yann LeCun شبکه Convolutional Neural Network(CNN) را معرفی کردند. در واقع آقای LeCun با برداشت از مدل آقای Fukushima و البته تئوریهایی که محققین عصبشناس از کورتکس بینایی انسان کشف کرده بودند مدلی به نام LeNet ایجاد کردند.

این مدل توانست دیتاست MNIST را به خوبی آموزش ببیند و در نهایت مدل مناسبی ایجاد شود. دیتاست MNIST یک دیتاست بسیار بزرگ بالغ بر 60000 تصویر میباشد که هر تصویر ارقام بین 0 تا 9 به صورت دستنویس میباشد. البته این مدل با توجه با سیستمهای پردازش آن زمان سه روز طول کشید تا آموزش ببیند که این موضوع بسیار حائز اهمیت بود.

در دهه 90 بزرگان زیادی مانند پروفسور Hinton کارهای مختلفی در زمینه دیپ لرنینگ انجام دادهاند. ولی به دو مساله مهم توجه نداشتند. که عبارتند از کمبود توان پردازشی سیستمهای موجود در آن زمان. و کمبود اطلاعات موجود به دلیل عدم گسترش اینترنت و در دسترس نبودن دیتاستهای بزرگ. که این امر موجب شد بحث دیپ لرنینگ خیلی موفقیت گستردهایی نداشته باشد. در بحث هوش مصنوعی در آن زمان بر روی مدلهای ریاضی مانند SVM ،HMM ،GMM و الگوریتمهایی مثل Gabor filters تمرکز شده بود.

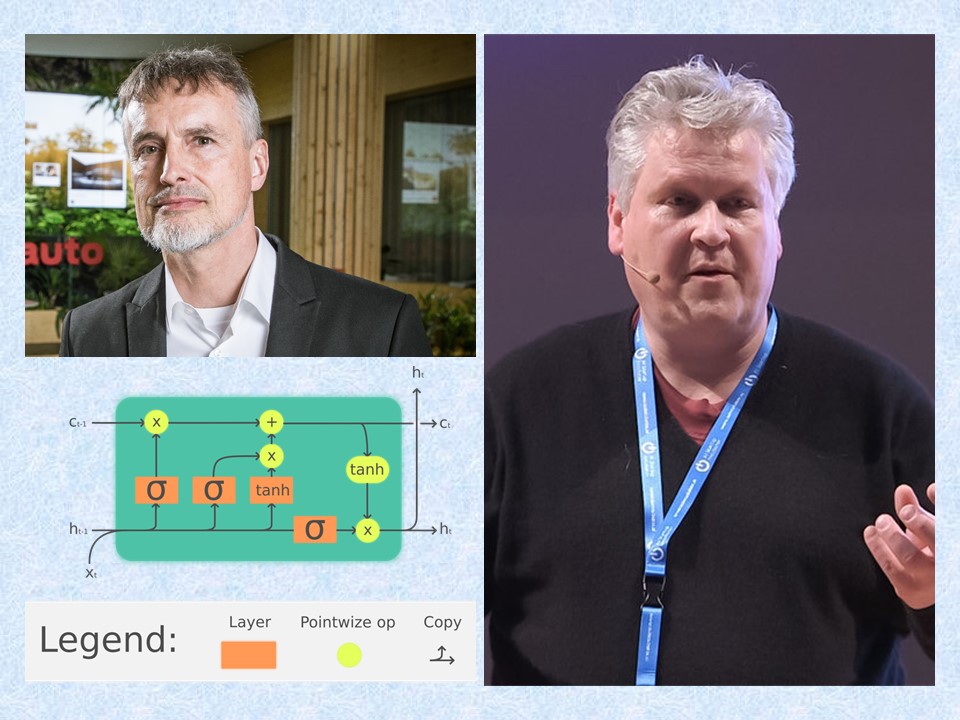

معرفی شبکههای LSTM

در سال 1997 یک اتفاق مهم دیگری نیز رخ داد. یک شبکه دیگری به اسم Long Short Term Memory(LSTM) توسط آقای Schmidhuber معرفی شد. این شبکه میتوانست در سریهای زمانی به خوبی اطلاعات را کشف کند و بخش حافظهایی که در اختیار داشت بسیار قدرتمند عمل میکرد. از این شبکه در بخش پردازش گفتار (Speech Processing) استفاده میشد.

انقلاب دیپ لرنینگ

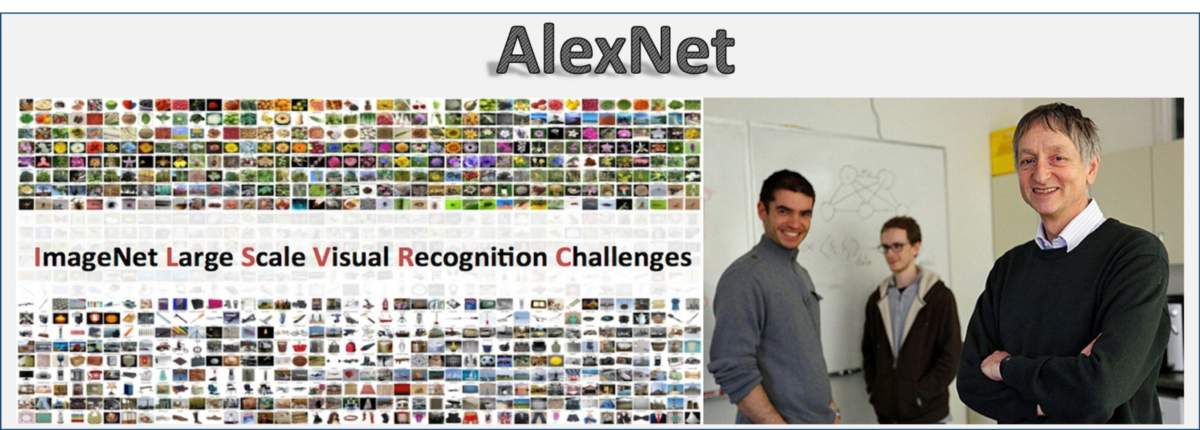

در سال 2006 آقای پروفسور Hinton و همکارانش تلاشهای دیگری را در خصوص رونق بحث دیپ لرنینگ داشتند. این تلاشها تا سال 2012 ادامه پیدا کرد و سرانجام انقلاب دیپ لرنینگ رخ داد. نقطه شروع این انقلاب سال 2010 بود که دیتابیسی به نام ImageNet توسط پروفسور Fei-Fei Li ایجاد شد. این دیتابیس دارای بیش از یک میلیون تصویر و هزار کلاس مختلف بود. یک چالشی ایجاد شد که محققین مختلف در آن شرکت میکردند. دو سال بعد در سال 2012 آقای Alex Krizhevsky شاگرد پروفسور Hinton در این چالش شرکت کردند. و مساله را با یک شبکه کانولوشنال دیگر که از شاخه دیپ لرنینگ بود، حل کردند.

زمانی این چالش حل شد که اول دیتاست بزرگی داشتند و دوم اینکه توسط پردازشگرهای موازی پردازشهای قدرتمندی ایجاد شد. از این زمان به بعد توجهات به سمت دیپ لرنینگ برگشت و دوباره شبکههای عمیق مورد استفاده قرار گرفت. امروزه بسیاری از سیستمها حتی گوگل از این شبکهها استفاده میکنند.

آموزش یادگیری عمیق در پایتون

برای آشنایی بیشتر با مبحث دیپ لرنینگ و نحوه کار با آن میتوانید به دوره جامع آموزش یادگیری عمیق در پایتون آکادمی رسا مراجعه کنید.